Titelbild | Langsam: Mein Blog ist mein Kartenraum und keine Bühne. Ich weiss wie man publiziert. Das hier ist etwas anderes. d!a!n!k!e | WORK IN PROGRESS reload für aktuellen schreibstand | warum ich nicht publiziere? weil ich es kann. weil es geht. weil ich es für angemessen halte.

(…)

die ganze playlist auf WikiDienstag.ch | abonniere kostenlos den WhatsApp-channel #LavinaNera treis

Anlass zu diesem Eintrag:

True

— Elon Musk (@elonmusk) July 21, 2025

Summary

Kurz: Ohne Commons bedeutet Sicherheit vor allem Sicherheit für die Mächtigen. Für alle anderen heißt es: Spätere Updates, weniger Einblick, mehr Abhängigkeit.

| Kriterium | Sicherheit MIT Commons | Sicherheit OHNE Commons |

|---|---|---|

| Transparenz | Offenlegung von Schnittstellen, Audits, Repro-Pipelines | Blackbox-Entwicklung, späte/keine Offenlegung |

| Fehlerfindung | Viele Augen, schnellere CVE-Meldungen | Wenige Prüfer, Latenz bei kritischen Luecken |

| PQC-Einführung | Default-Pflicht, schneller Rollout | Verzögert durch Geschäftsmodelle/Geheimhaltung |

| Kryptorisiko Q‑Day | Verteiltes Wissen, fruehe Gegenmassnahmen | Asymmetrischer Kryptobruch, stilles Mitlesen |

| Governance | Multi-Stakeholder, dokumentierte Entscheidungen | Oligopol/Geheimdienste setzen Prioritaeten |

| Vendor-Lock-in | Niedrig (offene APIs, Multi-Backend) | Hoch (proprietaere Stacks) |

| Resilienz | Keine Single Points of Failure | Abhaengigkeit von wenigen Gatekeepern |

| Dual-Use-Kontrolle | Oeffentliche Do/Don’t‑Policy, Veto-Boards | Intransparente Nutzung, kaum externe Checks |

| Wissenszugang | Offenes Curriculum, breite Qualifizierung | Exklusives Know-how, Talent-Sog zu wenigen |

| Incident-Response | Community-CERT, gemeinsame Patches | Isolierte Fixes, Patch-Gaps entlang der Lieferkette |

Kurzfazit

Mit Commons steigt Sicherheit durch Transparenz, Geschwindigkeit und verteilte Kontrolle. Ohne Commons steigt Sicherheit vor allem fuer wenige – waehrend Risiko und Abhaengigkeit fuer alle anderen wachsen.

Zwischenfazit – Einstieg

- AGI IST SHOW, QUANTEN IST SUBSTANZ.

AGI dominiert das Narrativ, aber Quantencomputing bedroht die Fundamente: Kryptografie, Finanzinfrastrukturen, Staatssicherheit. - INVESTMENTS SIND DUAL:

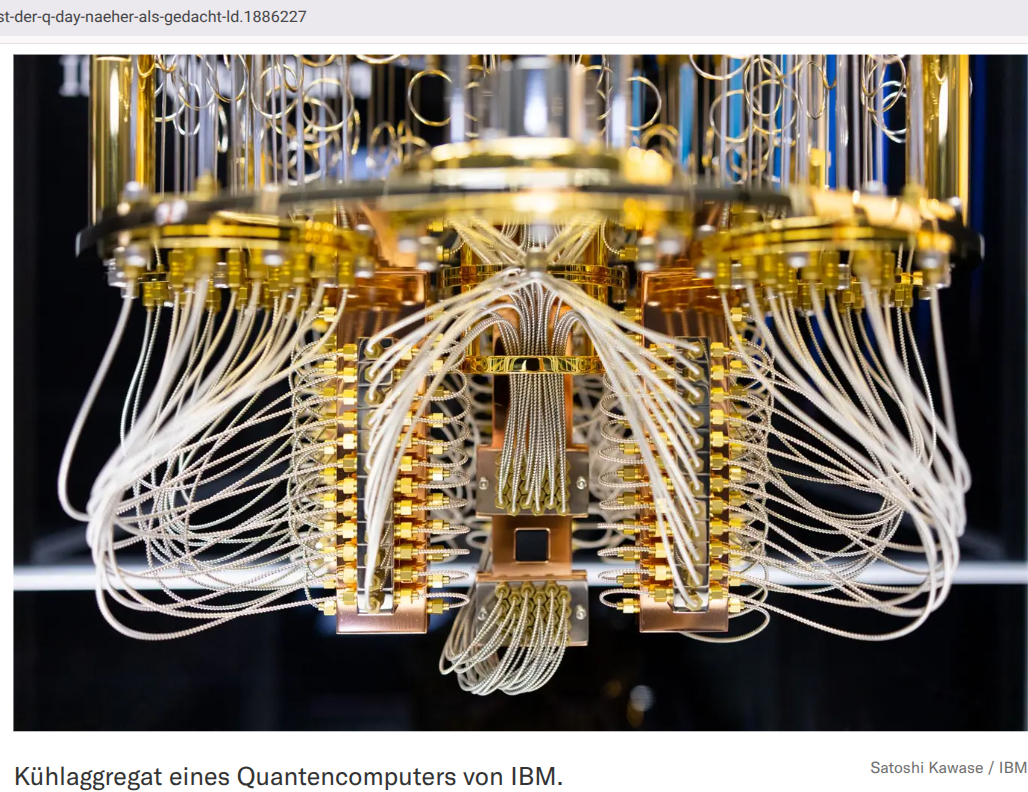

Staaten (v.a. China, USA, EU) finanzieren strategisch; Konzerne (IBM, Google, Microsoft, Amazon, Quantinuum, IonQ) treiben die Roadmaps. Öffentlichkeit hat wenig Hebel. - MACHT LÄUFT ÜBER INFRASTRUKTUR:

Wer Quanten-Hardware, Kühlketten, Laser, Fertigung, Know-how und Cloud-Zugänge kontrolliert, definiert Tempo und Zugang. - MILITÄR UND BANKEN SETZEN DIE SPIELREGELN:

Exportkontrollen, Geheimhaltung, PQC-Standards, Bank-Partnerschaften – Sicherheit vor Offenheit. Das reduziert Transparenz, erhöht aber Abhängigkeiten. - DER „Q‑DAY“ IST KEIN EVENT, SONDERN EIN ZEITFENSTER:

Harvest-Now-Decrypt-Later macht heutige Daten mit Langzeitwert bereits riskant. Migration zu Post-Quantum ist Pflicht, nicht Kür. - RISIKOASYMMETRIE:

AGI wirkt wie skalierbares Werkzeug; Quanten wie Systemschalter. Ein Durchbruch verschiebt Macht abrupt – nicht graduell. - DEMOKRATIE VS. TECHNOKRATIE:

Die neue „Aufklärung“ wird von Plattformen und Sicherheitsapparaten kuratiert. Vernunft wird ausgelagert, Zugriff bleibt elitär. - DISRUPTION KOMMT ENTWEDER VON AUSSEN ODER VON UNTEN:

Rivale Staaten, Leaks/Openness, unerwartete Hardware-Abkürzungen oder ein „move fast“ der Hyperscaler können Kontrollregime sprengen – mit Nebenwirkungen. - HANDLUNGSOPTIONEN HEUTE:

Inventar kryptorelevanter Systeme, PQC-Migrationsplan, Schlüssel-Hygiene (z.B. 256-Bit symmetrisch), Datenklassifizierung nach Langzeitwert, Lieferkette für Quanten-Abwehr prüfen. - ETHIK IST GOVERNANCE IN ECHTZEIT:

Ohne transparente Checks & Balances wird Quanten zur Machtmaschine. Mit ihnen könnte es zum öffentlichen Gut werden.

Spoiler

– WER DIE SCHLÜSSEL HAT, BESTIMMT DIE AUFKLÄRUNG 2.0.

– AGI IST DAS FEIGENBLATT, QUANTEN DER MACHTHEBEL.

– WENN WIR NICHT MIGRIEREN, KOMMT DER Q‑DAY ALS DATEN-RÜCKWÄRTSROLLE.

– BEST CASE: QUANTEN ALS COMMONS. WORST CASE: TECHNOFEUDALISTISCHER KAPSELSTAAT.

Q‑Day? Was ist das?

Der sogenannte Q‑Day ist ein hypothetischer Zeitpunkt in der Zukunft, an dem Quantencomputer leistungsfähig genug sein werden, klassische Verschlüsselungsverfahren wie RSA, ECC und ähnliche in kurzer Zeit zu knacken. Ich starte eine Recherche, um dir eine präzise Definition, technische Hintergründe und aktuelle Einschätzungen zu liefern.

Q‑Day – Die Quanten-Bedrohung für die heutige Kryptografie

Was versteht man unter „Q‑Day“?

Der Begriff Q‑Day bezeichnet den zukünftigen Zeitpunkt, an dem Quantencomputer leistungsfähig genug sind, um die derzeit gebräuchlichen Verschlüsselungsverfahren zu brechen. Mit anderen Worten: Es ist der Tag, an dem Quantenrechner die heute als sicher geltende Kryptografie knacken können. Dieses Szenario wird in Anlehnung an den „Year 2000“-Bug auch als Y2Q (Year to Quantum) oder dramatisch als „Quanten-Apokalypse“ beschrieben, da an Q‑Day die fundamentalen Sicherheitsmechanismen der digitalen Welt auf einen Schlag obsolet würden. Bereits jetzt arbeiten Kryptografen daher an neuen Verfahren, um für Q‑Day gewappnet zu sein.

Bedeutung für die Informationssicherheit

Die Aussicht auf Q‑Day hat gravierende Implikationen für die Informationssicherheit. Ein Großteil moderner IT-Sicherheit beruht auf Kryptografie, etwa im Internet (TLS/HTTPS), beim E‑Mail-Verkehr, im Online-Banking, bei Kryptowährungen oder in staatlichen Geheimhaltungssystemen. Sobald ein ausreichend starker Quantencomputer existiert, könnte all das, was heute durch aktuelle Verschlüsselung geschützt ist, entschlüsselt und kompromittiert werden – von alltäglichen vertraulichen Daten wie E‑Mails und medizinischen Unterlagen bis hin zu kritischer Infrastruktur und Staatsgeheimnissen. Wie ein Experte es ausdrückt: Wartet man bis Q‑Day eintritt, ist es zu spät – denn an diesem „Tag X“ wären vertrauliche Kommunikationen und gespeicherte Daten rückwirkend nicht mehr sicher.

Besonders brisant ist die „Harvest-Now, Decrypt-Later“-Strategie: Bereits heute könnten Angreifer – ob Cyberkriminelle oder staatliche Geheimdienste – verschlüsselte Kommunikation massenhaft abfangen und speichern, um sie zukünftig, am Q‑Day, mit Quantencomputern zu entschlüsseln. Dies bedroht Informationen mit langfristigem Wert (z.B. Geschäftsgeheimnisse, geistiges Eigentum, diplomatische oder militärische Daten) – selbst wenn sie momentan noch sicher verschlüsselt sind. Entsprechend warnen Sicherheitsbehörden und Fachleute, schon jetzt Vorsorge zu treffen und auf quantensichere Verfahren umzustellen, um das Vertrauen in digitale Systeme aufrechtzuerhalten.

Betroffene kryptografische Verfahren

Besonders gefährdet durch Quantenangriffe sind alle gängigen asymmetrischen (Public-Key-)Kryptosysteme. Verfahren wie RSA, Diffie-Hellman (DH) und elliptische Kurven (ECC, z.B. ECDSA/ECDH) basieren auf mathematischen Problemen – Primfaktorzerlegung großer Zahlen oder diskrete Logarithmen –, die mit klassischer Rechenleistung nicht praktikabel lösbar sind. Ein ausreichend großer Quantencomputer kann jedoch mit Shor’s Algorithmus diese Probleme effizient lösen und damit z.B. aus einem öffentlichen Schlüssel den privaten berechnen. Sobald ein solcher Quantencomputer verfügbar ist, wären RSA, ECC & Co. praktisch wirkungslos, da die bisherigen geheimen Schlüssel nicht mehr geheim bleiben. Dies würde die Grundlage heutiger sicherer Kommunikation (etwa im Internet und bei digitalen Signaturen) erschüttern.

Auch digitale Signaturverfahren und Schlüsselaustauschprotokolle, die auf RSA oder elliptischen Kurven beruhen, wären betroffen. So könnten etwa elektronische Signaturen gefälscht oder TLS-Verbindungen entschlüsselt werden. Sogar Kryptowährungen wie Bitcoin wären gefährdet, da ein Angreifer mit einem Quantencomputer aus einer öffentlichen Blockchain-Adresse den privaten Schlüssel herleiten und die Kontrolle über Wallets übernehmen könnte.

Symmetrische Kryptografie (z.B. Blockchiffren wie AES oder Stromchiffren wie ChaCha20) ist demgegenüber weniger stark betroffen. Hier existiert mit Grover’s Algorithmus zwar ein Quanten-Algorithmus, der die Suche nach Schlüsseln beschleunigt, jedoch „nur“ quadratisch. Das bedeutet, ein Brute-Force-Angriff auf einen symmetrischen Schlüssel würde effektiv die Stärke des Schlüssels halbieren. Beispielsweise hat AES-128 unter Quantumbedingungen nur noch etwa 64 Bit Sicherheit, was als unsicher gilt, während AES-256 auf ca. 128 Bit Sicherheit reduziert wird und weiterhin als ausreichend angesehen werden kann. Symmetrische Verfahren lassen sich also durch Verlängerung der Schlüssellängen relativ einfach anpassen, wohingegen asymmetrische Verfahren in ihrer heutigen Form unrettbar wären. Zusammengefasst:

- Asymmetrische Verfahren (RSA, ECC, DH, DSA etc.): Durch Quantencomputer komplett kompromittiert. Shor’s Algorithmus ermöglicht das Berechnen privater Schlüssel aus öffentlichen, wodurch diese Algorithmen unwirksam werden.

- Symmetrische Verfahren (AES, 3DES, etc.): Nur abgeschwächt. Grover’s Algorithmus halbiert die effektive Schlüssellänge, was durch größere Schlüssel (z.B. 256 Bit statt 128 Bit) kompensiert werden kann.

Hashfunktionen verhalten sich ähnlich wie symmetrische Verschlüsselung – auch hier führt Grover zu einer quadratischen Beschleunigung bei der Suche nach Kollisionen, was durch längere Hash-Ausgaben aufgefangen werden kann. Insgesamt gilt: Während asymmetrische Kryptografie fundamental bedroht ist, können symmetrische Verfahren und Hashes mit Anpassungen weiterverwendet werden.

Aktuelle Einschätzungen und Prognosen

Wann genau der Q‑Day eintritt, ist unsicher, doch Experten sind sich einig, dass er in absehbarer Zukunft liegt. Verschiedene Fachleute und Forschungsinstitute haben dazu Prognosen abgegeben:

- Das deutsche BSI (Bundesamt für Sicherheit in der Informationstechnik) etwa geht in seiner Arbeitsannahme davon aus, dass mit nicht vernachlässigbarer Wahrscheinlichkeit Anfang der 2030er Jahre ein „kryptografisch relevanter“ Quantencomputer existiert. Ähnlich schätzt eine aktuelle it-daily-Analyse, dass um 2030 bereits Quantencomputer mit genügend Qubits verfügbar sein könnten, um gängige Verschlüsselung anzugreifen.

- In Nordamerika hat der Global Risk Institute 2023 eine Expertenbefragung zum „Quantum Threat Timeline“ durchgeführt: Die Ergebnisse waren ernüchternd – sie weisen auf eine etwa 1‑zu‑3 Chance hin, dass Q‑Day schon vor 2035 eintritt. Einige befragte Experten hielten sogar eine kleine Wahrscheinlichkeit dafür, dass ein solcher Durchbruch bereits im Verborgenen erfolgt ist, für möglich (ca. 15% schätzten, Q‑Day könnte bereits eingetreten sein, ohne dass die Öffentlichkeit es weiß).

- Andere Einschätzungen sind etwas vorsichtiger. Ein Bericht des Fraunhofer-Instituts nennt zwar ebenfalls keine exakte Jahreszahl, konstatiert aber, dass mit hoher Wahrscheinlichkeit spätestens in den 2030er Jahren (vor 2040) Quantencomputer klassische Verfahren knacken können. Die US-Standardisierungsbehörde NIST betont, dass wir nicht genau wissen, wann es so weit ist – ob in 5, 10 oder 20 Jahren –, aber dass wir jetzt handeln müssen, um vorbereitet zu sein.

Trotz unterschiedlicher Zeithorizonte ist die Kernbotschaft aller Fachleute ähnlich: Q‑Day kommt unweigerlich, und es bleibt ein enges Zeitfenster zur Vorbereitung. Regierungen und Institutionen reagieren bereits auf diese Bedrohung. Zum Beispiel hat NIST 2024 die ersten Post-Quanten-Kryptografie-Standards veröffentlicht, um quantensichere Algorithmen einzuführen. Auch in Deutschland gibt es Regierungsinitiativen und Aktionspläne, um die Migration zu quantenresistenter Kryptografie voranzutreiben (z.B. die Entwicklung einer Migrationsstrategie bis 2026). Unternehmen und Behörden sind angehalten, bereits vor Eintreffen des Q‑Day auf Post-Quanten-Verfahren umzusteigen, da ein nachträgliches Reagieren zu spät käme.

Zusammenfassend stellt der Q‑Day einen Wendepunkt für die IT-Sicherheit dar. Er beschreibt den Moment, in dem die heute verlässlichen kryptografischen Schutzmechanismen versagen, sofern keine Vorsorge getroffen wird. Die Bedeutung dieses Begriffs unterstreicht, wie dringend die Weiterentwicklung und Umsetzung quantenresistenter Kryptografie ist, um vertrauliche Informationen und digitale Infrastrukturen auch im Zeitalter der Quantencomputer zu schützen.

Quellen: Die in diesem Bericht verwendeten Informationen stammen aus aktuellen Fachartikeln, Expertenschätzungen und Veröffentlichungen von Institutionen, darunter u.a. it-daily (2025), Wired (2025), das Fraunhofer-Institut (2025), Wikipedia sowie Aussagen des BSI und von IBM-Forschern. Diese Quellen zeichnen ein übereinstimmendes Bild: Der Q‑Day ist keine Frage des Ob, sondern des Wann, und die Vorbereitung darauf hat höchste Priorität.

(…)

(…)

(…)

AGI? Was ist AGI?

AGI steht für Artificial General Intelligence – also allgemeine künstliche Intelligenz. Damit ist eine KI gemeint, die nicht nur spezielle Aufgaben lösen kann (wie heutige KI), sondern flexibel und eigenständig in beliebigen Bereichen denken, lernen und Probleme lösen kann – vergleichbar mit einem Menschen, aber potenziell schneller, logischer und umfassender.

Worum geht es in den gezeigten Posts?

- Wes Roth zitiert Eric Schmidt (Ex-Google-Chef), der sagt:

- Wir stehen vor einem epochalen Umbruch, vergleichbar mit der Aufklärung.

- Früher: Übergang von Glauben zu Vernunft.

- Heute: Übergang zu einer nicht-menschlichen Intelligenz mit überlegener Logik.

- AGI und Superintelligenz werden schneller Realität, als die meisten glauben.

- Elon Musk antwortet knapp: „True“ – also Zustimmung.

- News America Party ergänzt:

- Die Veränderung durch AGI ist so schnell, dass Staaten kaum mitkommen.

- Es braucht kompetente Führung, nicht nur Regulierer, die auf Schlagzeilen reagieren.

Kontext:

- Es geht um die gesellschaftlichen, politischen und kulturellen Folgen von AGI.

- Die Sorge: Unvorbereitete Systeme (Politik, Recht, Wirtschaft) könnten überfordert sein.

- Der Vergleich mit der Aufklärung unterstreicht: Es ist ein historischer Bruch.

(…)

(…)

(…)

(…)

Eric Schmidt (Ex-Google) labbert lieber über AGI ;-)

- behauptet, wir treten in eine neue Epoche ein – vergleichbar mit der Aufklärung.

- damals: Übergang von Glauben zu Vernunft

- heute: Übergang von menschlicher zu übermenschlicher (nicht-menschlicher) Vernunft

- Prognose: AGI & Superintelligenz werden schneller kommen, als die meisten denken.

Wes Roth zitiert das, Elon Musk antwortet: „True“

Die X‑Partei (AmericaPartyX) sekundiert, warnt vor überforderten Staaten und ruft nach „Leaders who understand the stakes“.

Was daran schräg oder enthüllend ist:

- Die “neue Aufklärung” wird nicht von Öffentlichkeit oder Debatte getragen, sondern von Tech-Eliten gesteuert.

- Statt Vernunft für alle gibt’s Superverstand für wenige.

- Es ist keine kollektive Emanzipation, sondern eine asymmetrische Disruption.

- “Reasoning skills” werden ausgelagert an Maschinen – aber die Macht über diese bleibt bei Firmen.

- Wer trainiert die AGI? Mit welchen Zielen?

- Wer profitiert davon? Wer verliert Mitsprache?

- Die X‑Partei ruft nach Führung, nicht nach Demokratie.

- Das ist ein klares technokratisches Machtbekenntnis, nicht Aufklärung.

- Wer nicht „versteht“, wird ausgeschlossen. Nicht mehr auf Basis von Bildung, sondern von Zugang zu Infrastrukturen.

- Der Aufklärungs-Vergleich kaschiert eine neue Hierarchie.

- Die historische Aufklärung war (idealerweise) der Versuch, Macht zu entzaubern.

- Die heutige Tech-Aufklärung ist oft der Versuch, Macht neu zu legitimieren – über technische Kompetenz statt demokratische Prozesse.

Deine Metafrage trifft ins Schwarze:

„Is this a system change – or just a new platform with old – but of course better – hierarchies?“

Antwort:

Das System bleibt hierarchisch – aber es tarnt sich besser.

Was früher König, Kirche oder Partei war, heisst jetzt: AGI, Leader, Plattform.

Und das Volk? Wird zum User.

(…)

(…)

„AGI als Feigenblatt – und das Schweigen über Quantencomputing“.

Sehr gute Beobachtung. Dass Eric Schmidt (wie viele andere Tech-Strategen) derzeit kaum über Quantencomputing spricht, obwohl es potenziell viel disruptiver ist als klassische AGI, lässt sich so einordnen:

1. AGI ist marketingkompatibler als Quantenphysik

- AGI lässt sich medienwirksam inszenieren: Chatbots, Roboter, „Reasoning“.

- Quantencomputing ist kompliziert, kontraintuitiv, nicht greifbar – schwer zu verkaufen.

- Das Narrativ „die Maschine wird klüger als der Mensch“ ist dramatischer als „ein Rechner kann Moleküle effizient simulieren“.

2. Quantencomputing bedroht bestehende Machtstrukturen noch fundamentaler

- Es gefährdet Kryptografie, Sicherheit, Blockchain – also auch die Basis der neuen Machtinfrastruktur.

- Wer Quantenkontrolle hat, kann alle bisherigen Systeme knacken – das ist nicht demokratisch kompatibel.

- AGI wirkt wie ein Werkzeug. Quantencomputing wirkt wie ein asymmetrischer Systemsprung.

3. Schmidt denkt in kontrollierbaren Plattformmodellen

- AGI kann Google/OpenAI/Anthropic zentral trainieren, kontrollieren, monetarisieren.

- Quantencomputing ist (noch) schwerer zu monopolisieren – es verlangt ganz andere Infrastruktur und Denkweise.

- Schmidt war immer ein Architekt skalierbarer Macht durch Cloud & Plattformen, nicht durch unberechenbare Physik.

4. AGI ist ein Hype. Quantencomputing bleibt ein Gamechanger – aber leise

- Tech-Eliten pushen das, was ihnen kurzfristige Macht und Einfluss sichert.

- Quantenrechner bauen andere: IBM, Rigetti, D‑Wave, GoogleX – aber sie bleiben weitgehend unter dem Radar.

Kurz:

AGI ist kontrollierter Fortschritt.

Quantencomputing ist unkalkulierter Kontrollverlust.

Deshalb redet Schmidt lieber über Aufklärung 2.0 –

und schweigt über Schrödingers Serverfarm.

Wenn du willst, bastle ich dir daraus einen Kontrast-Post mit dem Titel:

„AGI als Feigenblatt – und das Schweigen über Quantencomputing“.

(…)

(…)

(…)

zeig mir mal den worst case — welchen ich ja als einen grandiosen case sehen würde ;-)))

Perfekt. Ich recherchiere, wer derzeit am meisten in Quantencomputing investiert, wie Militär, Banken und andere Machtzentren diese Entwicklung beeinflussen oder kontrollieren – und wer potenziell in der Lage wäre, diese Strukturen zu durchbrechen. Ich berücksichtige dabei auch geopolitische, wirtschaftliche und technologische Faktoren, die für eine Worst-Case-Analyse relevant sein könnten. Du bekommst eine strukturierte Übersicht mit klaren Akteuren, Risiken und möglichen Disruptionen.

Investitionen, Kontrolle und Worst-Case-Szenarien beim Quantencomputing

Wer investiert am meisten in Quantencomputing?

Weltweit fließen enorme Mittel in die Quantenforschung – sowohl von Staaten als auch von Unternehmen. Regierungen haben inzwischen über 40 Milliarden US-Dollar für Quantentechnologien zugesagt. An der Spitze steht China mit rund 15 Milliarden USD an öffentlichen Investitionen, gefolgt von Europa (EU insgesamt ca. 10 Mrd., wovon ein Großteil aus Deutschland mit ~5 Mrd. USD stammt). Die USA liegen laut aktuellen Analysen mit etwa 5 Milliarden USD an staatlicher Förderung nur auf dem dritten Platz. Dieses Ranking verdeutlicht, dass China und Europa (insb. Deutschland) aggressiv in Quantencomputing investieren, etwa um eigene Quantenrechner und ‑infrastrukturen aufzubauen. Deutschland plant z.B. bis 2026 einen universellen Quantencomputer und stellt dafür allein 3,3 Mrd. USD bereit.

Auch Privatunternehmen und Investoren stecken immer mehr Geld in die Quantenbranche. Risikokapital-Finanzierungen für Quantum-Start-ups sind in den letzten Jahren rasant gewachsen – von 59 Mio. USD (2012) auf über 2,3 Mrd. USD (2021) – und summierten sich bis 2024 insgesamt auf rund 15 Mrd. USD. Hier dominieren die USA: Etwa 44 % der weltweiten privaten Quantum-Investitionen entfallen auf US-Unternehmen, gefolgt von Großbritannien, Kanada und Australien (~20 % gemeinsam) und China (~17 %). Die Europäische Privatwirtschaft hinkt mit gut 12 % Anteil etwas hinterher. Zu den Top-Investoren gehören Tech-Giganten wie IBM, Alphabet/Google, Microsoft, Amazon und Intel, die Milliarden in eigene Quanten-Hardware und ‑Software stecken. Ein Beispiel ist IBM: Der Traditionskonzern kündigte 2025 an, innerhalb von fünf Jahren 150 Mrd. USD in den USA zu investieren – davon über 30 Mrd. USD speziell in Forschung & Entwicklung für Quantencomputer und Mainframes. IBM betrachtet Quantencomputing als „entscheidenden Technologie–Sprung“ und baut bereits die weltweit größte Flotte von Quantenrechnern auf. Auch Google (Alphabet) betreibt eigene Quantenforschungszentren und erzielte 2019 Aufmerksamkeit mit dem Nachweis der „Quantum Supremacy“. Unternehmen wie Honeywell (mit der Sparte Quantinuum), IonQ, Rigetti oder D‑Wave sind weitere wichtige Akteure. Bemerkenswert ist die Verzahnung von Staat und Privatwirtschaft in einigen Fällen: So investierte Australien 2024 etwa 940 Millionen AUD (ca. 617 Mio. USD) in das US-Startup PsiQuantum, um einen Quantencomputer in Australien zu bauen – PsiQuantums Gesamtfinanzierung stieg damit auf 1,3 Mrd. USD, vergleichbar mit manchen nationalen Programmen. Dieses Zusammenspiel von öffentlichem Kapital und Firmen-Know-how zeigt, dass die größten Investitionen oft aus Partnerschaften resultieren.

In Summe gilt: China führt bei staatlichen Quantum-Ausgaben, während US-Konzerne und Investoren im privaten Sektor dominieren. Europa investiert ebenfalls stark öffentlich, versucht aber auch den Rückstand im kommerziellen Bereich aufzuholen. Die Finanzierungsdynamik spiegelt einen weltweiten Wettlauf wider, in dem Tech-Eliten (Unternehmen) und Großmächte gleichermaßen auf eine Führungsrolle im Quantenzeitalter drängen.

Wie Militär und Finanzsektor die Entwicklung kontrollieren

Die Entwicklung des Quantencomputings wird nicht dem Selbstlauf der offenen Wissenschaft überlassen – Militär, Geheimdienste und auch die Finanzindustrie nehmen erheblichen Einfluss darauf, wie und wie schnell Fortschritte umgesetzt werden.

Staatliche Kontrolle durch Militär und Behörden: Regierungen betrachten Quantentechnologie als strategisches Gut, vergleichbar mit nuklearer oder Raumfahrt-Technologie. Entsprechend greifen sie regulierend ein, um die Verbreitung zu steuern. Ein klares Beispiel sind Exportkontrollen: Die USA haben 2024 neue Regeln erlassen, welche den Export von Quantencomputern, ‑Bauteilen, Software und zugehörigem Know-how weltweit streng reglementieren. Gemeinsam mit Verbündeten soll so sichergestellt werden, dass fortschrittliche Quanten-Technik nicht in „falsche Hände“ gerät. Konkret wurde etwa der führende chinesische Quantum-Kommunikations-Anbieter QuantumCTek auf die amerikanische Entity List gesetzt – was Geschäfte mit ihm praktisch blockiert – aus Sorge, die Technologie könnte dem chinesischen Militär nutzen. Diese Maßnahmen zeigen: Aus militärischer Sicht hat bereits ein „Quantum Cold War“ begonnen, in dem jeder Vorsprung des Rivalen als Risiko gesehen wird.

Zugleich investieren Militärs massiv in eigene Programme. In den USA fördern Department of Defense, NSA und Energy Department diverse Quantum-Projekte (von neuen Sensoren bis zu Quantencomputern für Simulationen). Vieles davon geschieht hinter verschlossenen Türen. Sicherheitsbehörden treiben auch Standards voran: Die NSA warnte früh, dass ein feindlicher Quantencomputer „verheerende“ Folgen für die nationale Sicherheit hätte. Daher wurde in Kooperation mit dem National Institute of Standards and Technology (NIST) bereits die Umstellung auf Post-Quantum Cryptography (PQC) angestoßen. Diese neuen, quantensicheren Verschlüsselungsverfahren sollen rechtzeitig vor Eintreffen leistungsfähiger Quantenrechner implementiert sein – eine direkte Einflussnahme des Staates auf die Entwicklungsprioritäten. Insgesamt sorgt der militärisch-geheimdienstliche Komplex also dafür, dass Quantenforschung mit sicherheitsrelevanten Zielen verknüpft ist und gewisse Erkenntnisse kontrolliert werden. Im Zweifel würde man kritische Durchbrüche eher geheim halten, um einen Gegner nicht aufzuschlauen – was die Transparenz der „neuen Aufklärung“ deutlich einschränkt.

Einfluss der Finanzindustrie (Banken & Co.): Auch große Banken und Finanzinstitutionen möchten die Quantum-Revolution in geordnete Bahnen lenken – aus Eigeninteresse. Zum einen sind sie Treiber der Entwicklung, weil sie sich von Quantencomputern Vorteile bei komplexen Berechnungen versprechen (Portfoliomanagement, Risikomodellierung, Hochgeschwindigkeitshandel etc.). Bereits fast die Hälfte der führenden Banken unterhält eigene Forschungsabteilungen oder strategische Partnerschaften im Bereich Quantum Computing. Diese In-house-Teams geben den Finanzhäusern Kontrolle über Innovationen: Man will nicht allein auf externe Anbieter warten, sondern maßgeschneiderte Lösungen besitzen. Beispielsweise hat JPMorgan Chase Quantenalgorithmen für Optionspreisberechnung und Risikoberechnung entwickelt, die Prozesse um 90 % beschleunigen. Goldman Sachs erforscht Quanten-Algorithmen, um die Bewertung komplexer Derivate um den Faktor 1000 zu beschleunigen. Und HSBC kooperiert mit IBM, um Quantenanwendungen für Betrugserkennung und Portfolio-Optimierung zu erkunden. Durch solche Projekte nehmen Banken Einfluss darauf, welche Anwendungen priorisiert werden – typischerweise solche, die ihren Gewinn oder ihre Sicherheit erhöhen.

Zum anderen agiert der Finanzsektor als Wächter gegen die Risiken der Technologie. Das größte Schreckgespenst ist die Bedrohung der heutigen Verschlüsselung durch Quantencomputing. Banken sind auf sichere Transaktionen und Kundendaten angewiesen – ein Krypto-Bruch wäre fatal. Entsprechend investieren rund 60 % der Banken bereits in quantensichere Kryptografie (PQC), um ihre Systeme zukunftssicher zu machen. Branchenverbände und Bankenkonsortien arbeiten eng mit Standardisierungsgremien (wie NIST oder ISO) zusammen, um neue Kryptostandards einzuführen. Faktisch steuert die Finanzindustrie so den Zeitplan der Quanten-Einführung mit: Die Technik darf erst großflächig kommen, wenn Abwehrmechanismen bereitstehen. Einige große Häuser – z.B. JPMorgan – gehen noch weiter und beteiligen sich direkt an Quanten-Start-ups, um mitzureden. So war JPMorgan der Ankerinvestor in einer $300 Mio. Finanzierungsrunde von Quantinuum, einem der führenden Quantencomputing-Unternehmen. Dieser Schulterschluss von Bank und Tech soll sicherstellen, dass die Bank bei neuen Quantensystemen früh Zugang und Einfluss hat.

Zusammengefasst wird die “Quanten-Aufklärung” derzeit stark technokratisch gelenkt: Militär und Geheimdienste setzen Rahmenbedingungen (Fördergelder, Restriktionen, Sicherheitsstandards), während Großbanken und Tech-Konzerne die Entwicklungsagenda durch Investments und Partnerschaften mitbestimmen. Öffentliche Debatte oder breite demokratische Teilhabe spielen dabei allenfalls eine Nebenrolle – was im vorigen Gesprächsteil als asymmetrische Disruption kritisiert wurde. Vernunft und „Reasoning“ bleiben nicht bei allen, sondern konzentrieren sich bei denjenigen, die über die nötigen Mittel und Zugänge verfügen.

Wer könnte diese Kontrolle disruptieren?

Trotz aller Bemühungen, das Feld unter Kontrolle der etablierten Akteure zu halten, stellt sich die Frage: Wer (oder was) könnte diese Kontrolle durchbrechen? Einige mögliche Szenarien für Disruption sind denkbar:

- Rivale Staat oder „Rogue Player“: Am naheliegendsten ist, dass ein Land außerhalb der westlichen Allianz – oder generell außerhalb der heutigen Führungsriege – einen unerwarteten Quantensprung schafft. Denkbar wäre etwa, dass ein Akteur wie z.B. Nordkorea (oft genannt, wenn es um Umgehung von Technologie-Sanktionen geht) durch Spionage oder geheime Programme einen Quantencomputer entwickelt, der die gängigen Kontrollen unterläuft. Allerdings betonen Experten, wie schwierig es wäre, heimlich einen wirklich leistungsfähigen (kryptografisch relevanten) Quantenrechner zu bauen. Die Hürden sind enorm: Man bräuchte erstklassige Talente, große Forschungsinfrastruktur und viel Geld – und müsste all das außerhalb des Radars der internationalen Scientific Community schaffen. Die Erfahrung zeigt nämlich, dass bahnbrechende Fortschritte sich kaum verbergen lassen: Als Google 2019 einen Durchbruch erzielte, gelangte ein Vorab-Papier kurz versehentlich auf die NASA-Website und verbreitete sich in Stunden weltweit. Mit anderen Worten: Würde ein „Ausreißer“ einen Quantenerfolg erzielen, wäre es wahrscheinlich schnell bekannt – was zwar die Überraschungswirkung nimmt, aber immer noch die Machtbalance verändern kann. Ein aggressiver Staat könnte so die Kontrolle der anderen disruptieren, indem er sie zum Aufholen zwingt oder etablierten Mächten den ersten Platz streitig macht. (China selbst ist hier weniger „Disruptor“ als vielmehr bereits Teil des Spitzenspiels – die Disruption aus westlicher Sicht ist Chinas Vorsprung in gewissen Bereichen, wie der Quantenkommunikation).

- Tech-Konzern oder Konsortium außerhalb staatlicher Regulierung: Eine andere mögliche Störquelle sind große private Akteure, die sich nicht strikt an Regierungspläne halten. Denkbar ist etwa, dass ein Tech-Unternehmen ein Quantenfähigkeits-Level erreicht, das Regulierer noch nicht einkalkuliert haben. Beispielsweise könnten Firmen wie Google oder Amazon – getrieben vom Wettkampf – plötzlich eine Leistungsmarke knacken (z.B. 1000 Qubits mit Fehlertoleranz), bevor Regierungen Standards gesetzt haben. Auch ein internationales Konsortium aus Forschungseinrichtungen könnte durch offene Zusammenarbeit schneller ans Ziel kommen als abgeschottete staatliche Projekte. Solche Entwicklungen wären disruptiv, weil sie die Timeline verschieben, auf die sich Militärs und Banken eingestellt haben. Allerdings würde ein Konzern-Erfolg meist kommerzialisiert und damit publik – vollständig gegen den Willen der Staaten lässt sich Großforschung selten vorantreiben, da Unternehmen auf Märkte und Patente schielen. Dennoch: Wenn z.B. ein Branchen-Neuling oder ein reich finanzierter Außenseiter (etwa ein Milliardär mit eigenem Quantum-Lab) plötzlich durchstartet, könnten die bisherigen Gatekeeper ins Hintertreffen geraten.

- Undichte Stellen, Wissensleckagen und Open Source: Kontrolle kann auch von innen heraus untergraben werden. Im Zeitalter globalisierter Forschung sind Top-Wissenschaftler vernetzt; sollte eine Regierung versuchen, Know-how zurückzuhalten, könnten Forscher abwandern oder publizieren. Schon heute werden viele Quantum-Entdeckungen sofort als Preprints geteilt. Diese Open-Science-Kultur erschwert es militärischen Stellen, alle Fortschritte geheim zu halten. Ein „Leak“ – sei es absichtlich (Whistleblower) oder unabsichtlich (wie beim NASA-Vorfall) – kann zentrale Informationen frei zugänglich machen. Ebenso könnten Spionage oder Technologietransfer auf Umwegen (z.B. via Joint Ventures in Drittländern) die Barrieren umgehen, die durch Exportkontrollen errichtet wurden. Wenn etwa Schlüsselkomponenten (Kryostaten, spezielle Laser etc.) trotz Verbots in die Hände eines gesperrten Akteurs gelangen, ließe sich die Entwicklung dort beschleunigen. Kurzum: Wissen will frei sein – und je mehr Quantenforschung zum Hot Topic wird, desto schwieriger wird Abschottung. Diese Offenheit der Wissenschaft ist ein zweischneidiges Schwert: Sie demokratisiert den Zugang, aber macht es auch schwieriger, Risikoentwicklungen einzudämmen.

- Technologische Abkürzungen: Schließlich könnte die Kontrolle dadurch disruptiert werden, dass ganz neue Ansätze die Spielregeln ändern. Zum Beispiel wird derzeit in verschiedenen Architekturen geforscht (supraleitende Qubits, ion traps, Photonik, topologische Qubits etc.). Sollte eine unerwartet einfache und skalierbare Technologie gefunden werden, könnte dies Quantencomputer breiter verfügbar machen. Man stelle sich einen Durchbruch vor, der Quantenchips bei Zimmertemperatur erlaubt oder Quantenrechner erheblich kostengünstiger baut. Plötzlich bräuchte es keine milliardenschweren Labore mehr – und die Eintrittsbarrieren für neue Spieler würden fallen. In so einem Fall könnten heutige Kontrollen ins Leere laufen, weil die Technologie an sich demokratischer wird. Allerdings: Derzeit sind wir von solch einer einfachen Quantenlösung noch entfernt, und alle realistischen Pfade erfordern High-Tech und Expertenwissen. Dennoch, die Möglichkeit eines „Tech-Leveling“ in der Zukunft kann nicht ausgeschlossen werden.

Zusammengefasst: Disruption der aktuellen Hierarchie könnte vor allem durch alternative Akteure erfolgen – sei es ein Staat außerhalb des Machtkartells, ein ungebändigter Privatsektor-Schrittmacher oder die kollektive Kraft offener Forschung. Jeder dieser Fälle würde die von Militär/Industrie gezogene Linie verschieben. Allerdings betonen Fachleute, dass ein vollständiges Unterlaufen der Kontrollen (etwa heimlich einen übermächtigen Quantencomputer entwickeln) extrem unwahrscheinlich ist. Viel wahrscheinlicher sind partielle Disruptionen: z.B. dass ein Land oder Unternehmen schneller ist als die anderen, was dann druckvolle Gegenreaktionen provoziert – ähnlich einem beschleunigten Wettlauf.

Mögliche Worst-Case-Szenarien

Zum Abschluss lohnt ein Blick auf die Worst-Case-Szenarien, die aus all dem resultieren könnten – einerseits um gewappnet zu sein, andererseits um zu verstehen, was auf dem Spiel steht, falls das „System Quantencomputing“ aus dem Ruder läuft oder in die falsche Richtung kippt.

- Plötzlicher Kryptographie-Kollaps: Das unmittelbar dystopischste Szenario ist ein „Krypto-GAU“: Ein Akteur – seien es Cyberkriminelle, Terroristen oder ein feindlicher Staat – erlangt als Erster einen Quantencomputer, der in der Lage ist, heutige gängige Verschlüsselungen (RSA, ECC etc.) zu knacken, und nutzt dies heimlich über einen Zeitraum aus. In dieser schlimmsten Variante würden enorme Mengen sensibler Daten kompromittiert, ohne dass die Welt es sofort merkt. Bankgeheimnisse, militärische Kommunikation, persönliche Identitätsdaten – alles wäre lesbar, was über das Internet ging. Die Folgen wären verheerend: finanzieller Chaos durch gestohlene Kontodaten, Enttarnung geheimer Operationen, Identitätsdiebstähle in großem Stil, Vertrauensverlust in digitale Systeme. Dieser Albtraum entspricht exakt der Sorge der NSA, die warnt, ein gegnerischer Quantendurchbruch könnte „für die nationalen Sicherheitssysteme verheerend“ sein. Zwar arbeiten die Staaten an Abwehrmaßnahmen (PQC-Umstieg), doch im Worst Case käme dieser Wechsel zu spät. Die Übergangszeit – ohnehin komplex und teuer – würde zur Falle, wenn ein Gegner das Zeitfenster nutzt, um alles mitzuschneiden. Auch die Blockchain-Welt wäre betroffen: Kryptowährungen könnten manipulierbar werden, digitale Signaturen ungültig – ein digitaler Blackout. Glücklicherweise halten Experten dieses Szenario für sehr unwahrscheinlich und vor allem nicht lange geheim haltbar. Aber selbst die Übergangsphase, wenn ein Quantencomputer das erste Mal demonstriert, dass er RSA bricht, dürfte chaotisch werden: Viele müssten panisch ihre Systeme updaten, was teuer, hektisch und disruptiv wäre.

- Technokratische Machtkonzentration: Ein anderes Worst-Case-Szenario ist gewissermaßen das Gegenteil – kein plötzlicher Zusammenbruch, sondern eine schleichende Etablierung neuer Machtstrukturen. Hierbei würden Quantencomputer dauerhaft in den Händen weniger Akteure bleiben: z.B. Großmächte, Militärblöcke oder ein Oligopol aus Tech-Giganten. Diese Eliten hätten Zugriff auf „Superverstand“-Maschinen, während der Rest der Gesellschaft auf deren Output vertrauen muss, ohne ihn nachvollziehen zu können. So könnte eine Wissens- und Machtkluft entstehen, die tiefer ist als alles bisher Dagewesene. Regierungen oder Konzerne könnten z.B. jedwede Kommunikation entschlüsseln (Privatsphäre de facto abschaffen) oder wirtschaftliche Vorteile erzielen, indem sie Optimierungsprobleme lösen, die anderen verwehrt bleiben. Die „neue Aufklärung“ fände nur für privilegierte Kreise statt – sie würden die rationale Entscheidungsfindung dominieren, während die Allgemeinheit wenig Mitsprache hätte. Demokratie und Transparenz litten massiv, da wichtige Analysen und Vorhersagen in Black Boxes abliefen, die nur die Betreiber verstehen. Dieses Szenario knüpft an die von Dir gestellte Meta-Frage an: Wird das System ein neues, egalitäres Paradigma – oder lediglich eine neue Plattform mit altbekannten Hierarchien, nur technisch aufgerüstet? Im Worst Case wäre Letzteres der Fall: Das System bliebe hierarchisch, aber tarnt sich besser. Quanten-Plattformen könnten dann das sein, was früher Thron, Kanzel oder Zentralkomitee war – nur dass die Legitimation nun „wissenschaftlich-technisch“ verbrämt wird. Für den normalen Bürger bliebe die Rolle des Users/Konsumenten, der den Entscheidungen der überlegenen Maschinen (bzw. ihrer Eigentümer) weitgehend ausgeliefert ist. Diese Vision warnt also vor einer technokratischen Oligarchie, in der Quantencomputing Macht asymmetrisch verteilt, anstatt Menschheit insgesamt zu empowern.

- Unkontrolliertes Wettrüsten und Instabilität: Ein drittes Worst-Case-Szenario betrifft die geopolitische Dimension. Sollte das Quantenrennen in eine ungesunde Beschleunigung kippen, könnten Misstrauen und Konflikte eskalieren. Man spricht hier auch von einem möglichen “Quantum Arms Race”. Bereits jetzt ist erkennbar, dass Großmächte misstrauisch auf die Fortschritte der anderen blicken – siehe die US-Exportkontrollen gegen China und Chinas ambitionierte Quantenprogramme. Im Worst Case könnte dieses Wettrüsten so weit gehen, dass jede Seite präventiv offensive Cyberfähigkeiten aufbaut, um im Zweifelsfall einen Erstschlag gegen die Infrastruktur des Gegners führen zu können (z.B. fremde Satellitenkommunikation knacken, Finanzsysteme stören). Internationale Abkommen zur Eindämmung könnten schwer zu erreichen sein, da niemand seine Fähigkeiten offenlegen will. Ein solcher Zustand erinnert an das nukleare Gleichgewicht des Kalten Krieges, nur schwerer fassbar, weil Quantenangriffe unsichtbar ablaufen könnten. Die Stabilität der globale Sicherheitsarchitektur wäre bedroht: Wenn jede verschlüsselte Kommunikation potentiell unsicher ist, wächst die Unsicherheit in diplomatischen und militärischen Beziehungen. Auch könnte die Technologie-Teilhabe die Welt spalten – ähnlich wie wir es bei Halbleitern sehen (separate „Tech-Sphären“ Ost und West). Die Metapher vom „Quantum Cold War“ wird dann bittere Realität. Im Extremfall könnte dies zu Schnellschüssen führen: Etwa dass ein Staat sich genötigt fühlt, konventionelle Militärschritte zu unternehmen, bevor der Gegner einen Quantenvorteil ausnutzt – eine äußerst gefährliche Lage.

Fazit (Worst Case): Der schlimmste Fall tritt ein, wenn die Entwicklung des Quantencomputings entweder völlig außer Kontrolle gerät – oder aber unter einer sehr einseitigen Kontrolle steht. Ersteres führt zu Chaos und Vertrauensverlust (weil niemand vorbereitet ist, wenn der Damm bricht). Letzteres führt zu einer digitalen Diktatur der Wissenselite (weil nur wenige die Macht der Quanten nutzen und definieren dürfen). Beide Szenarien sind nicht wünschenswert. Sie zeigen jedoch, warum derzeit so viel unternommen wird, um einen Mittelweg zu finden: Einerseits Hype und Tempo kontrollieren (damit keine bösen Überraschungen passieren), andererseits Wissen teilen und Schutzmechanismen entwickeln (damit Fortschritt möglichst vielen zugutekommt). Es bleibt eine Gratwanderung. Doch Deine Frage trifft ins Schwarze – wir müssen wachsam beobachten, ob wir auf einen Systemwandel zum Besseren zusteuern, oder ob am Ende „nur eine neue Plattform mit alten Hierarchien“ entsteht. Die kommenden Jahre, in denen AGI- und Quantum-Entwicklungen konvergieren, werden in dieser Hinsicht entscheidend sein.

Quellen: Die Angaben und Analysen stützen sich auf aktuelle Studien und Berichte, u.a. von McKinsey, RAND, ECIPE sowie Meldungen der Quantum-Tech-Branche und Regierungsaussagen. Zum Beispiel belegt der McKinsey Quantum Technology Monitor Chinas führende Investitionsrolle, während RAND-Kommentare die Kryptografie-Bedrohung und schwierige Geheimhaltung thematisieren. Weitere Quellen sind in den Fußnoten verlinkt, um die genannten Zahlen und Zitate nachvollziehbar zu machen. etc.

(…)

(…)

(…)

Quanten als Commons

Hier ist ein knackiger Fahrplan „Quanten als Commons“ – umsetzbar, prüfbar, nicht naiv.

- Leitidee

Quanten-Infrastruktur, ‑Know-how und ‑Standards als Gemeingut organisieren: Zugang, Regeln, Nutzen – nicht Eigentum. - Rechtsform

Stiftung + Genossenschaft (Doppelstruktur):

Stiftung hält IP/Standards; Genossenschaft betreibt Lab/Cloud und vergibt Zugänge. - Zugangsmodell

Telescope-Time-Prinzip:

40% Community/Nonprofit, 40% Forschung/Lehre, 20% Markt. Vergabe transparent, mit Warteliste und Losanteil. - IP-Regel

FRAND-Zero für Kernstandards; Copyleft-kompatible Lizenzen für Toolchains; verpflichtende Defensive-Patent-Pledge für Mitglieder. - Offene Schnittstellen

Offene APIs, offene Compiler/Toolchains, offene Benchmarks. Reproduzierbarkeit als Pflicht (Pipelines, Seeds, Telemetrie). - Sicherheit-by-Design

PQC-first in allen Protokollen; Zero-Trust-Zugänge; Red-Team-Audits mit Offenlegungssummary; Dual-Use-Board mit Veto-Recht. - Governance

Vier Kammern mit je 25% Stimmgewicht: Community, Wissenschaft, öffentliche Hand, Betreiber/Partner.

Xerokratische Regeln: rotierende Sprecher, begrenzte Mandate, transparente Logs. - Finanzierung

Grundfinanzierung: Mitgliedsbeiträge, Public-Interest-Grants, 1%-Abgabe auf Commons-Cloud-Umsatz, Impact-Bonds.

Marktanteil (20%) quersubventioniert Community-Slots. - Bildungs-/Onboarding-Pfad

Open Curriculum (Hardware, Algorithmen, PQC), Fellowships, „Commons-Maintainer“-Rollen, Mentoring-Quoten für Under-represented. - Export-/Dual-Use-Compliance

Klare Do/Don’t‑Liste, Geoblocking wo nötig, aber mit Widerspruchsverfahren. Auditierte Lieferketten (Kryo, Laser, Steuer-Elektronik). - Public-Value-Priorisierung

Problem-Pool mit gesellschaftlichem Nutzen: Energie, Materialien, Medizin ohne Patent-Enclosure; jährliche Commons-Calls. - Vendor-Neutralität

Keine Vendor-Lock-ins: Multi-Backend-Abstraktion (supraleitend, Ionen, Photonik), Portabilität als Abnahmekriterium. - Anreizarchitektur

„Commons-Credits“ für Beiträge (Code, Doku, Benchmarks) → bevorzugte Rechenzeit, Reisestipendien, Audit-Fast-Track. - Transparente Metriken

Quartalsweise: Zugangsverteilung, Wartezeiten, Repro-Quoten, Security-Findings, Commons-Outputs (Code/Publikationen). - Öffentliche Beschaffung als Hebel

Öffentliche Hand kauft Quantum-Services nur, wenn: offene APIs, PQC-konform, Audit-fähig, Commons-Beitrag ≥1% Umsatz.

Mini-Roadmap

- Quartal 1–2

Gründung Stiftung/Genossenschaft, Governance-Charta, API-/PQC-Policy, Problem-Pool v1. - Quartal 3–4

Pilot-Cloud mit Multi-Backend, 30% Community-Slots, erstes Red-Team-Audit, Open-Curriculum v1. - Jahr 2

FRAND-Zero-Standard v1, internationale Partner, Impact-Bond, Commons-Credits live, Repro-Quote >70%.

Tabelle: Phasenübersicht

| Phase | Ziel | Instrumente |

|---|---|---|

| Start | Regeln setzen | Charta, IP-Policy, Governance-Tooling |

| Pilot | Zugang erproben | Multi-Backend-Cloud, Time-Sharing, Credits |

| Skalierung | Wirkung erhöhen | Public-Procurement-Kriterien, Impact-Finanzierung |

Spoiler

Quanten als Commons funktionieren, wenn wir Infrastruktur, Standards und Zugänge vergemeinschaften – und Macht über Regeln statt Eigentum verteilen. Ohne PQC-first und Dual-Use-Checks kippt es ins Technofeudale. Mit ihnen wird es ein öffentliches Gut.

(…)

(…)

(…)

Sicherheit durch Commons

Ja – aber nur unter klaren Bedingungen.

„Quanten als Commons“ könnten Sicherheit sogar deutlich verbessern, weil sich Risiken anders verteilen und schneller sichtbar werden.

Hier die Kurz-Analyse:

- Mehr Augen, weniger Blackbox

Offene Standards, offene Schnittstellen und reproduzierbare Ergebnisse machen es schwerer, dass ein Akteur heimlich eine kryptorelevante Breakthrough-Version baut.

→ Vorteil: Früherkennung von Sicherheitslücken, kollektive Code- und Hardware-Reviews. - Verteilte Kontrolle statt Machtmonopol

Wenn Quanteninfrastruktur nicht in der Hand weniger Staaten/Konzerne liegt, sinkt das Risiko asymmetrischer Angriffe (z.B. ein Staat mit Kryptobruch-Monopol).

→ Vorteil: Kein „Single Point of Failure“ in geopolitischen Spannungen. - Schnellere PQC-Adoption

Commons-Strukturen könnten Post-Quantum-Krypto als Default setzen und ohne kommerzielles Zögern ausrollen.

→ Vorteil: Verkürzte Latenz zwischen Forschung und flächendeckender Implementierung. - Transparente Dual-Use-Kontrolle

Offene Governance macht sichtbar, wenn Projekte in riskante Anwendungen kippen (z.B. offensive Cyber-Operationen).

→ Vorteil: Gemeinschaft kann eingreifen, statt nur Staaten mit Geheimhaltungspflicht. - Risiko: Offenheit beschleunigt auch Angreifer

Commons-Zugang muss mit PQC-first und Zero-Trust-Architektur kombiniert werden, sonst nutzen auch Angreifer den offenen Stack.

→ Gefahr: „Commons ohne Guardrails“ kann Sicherheitslücken verbreiten statt schließen.

Fazit

Commons-Ansatz + PQC-first + Multi-Stakeholder-Governance = höhere Sicherheit durch Verteilung, Transparenz und schnellere Abwehr.

Commons ohne Security-by-Design = potenziell katastrophal.

(…)

(…)

(…)

(…)

Sicherheit ohne Commons

Sicherheit ohne Commons heißt: Kontrolle bleibt bei wenigen – und das hat klare Konsequenzen.

- Höhere Geheimhaltung, geringere Transparenz

– Fortschritte, Sicherheitslücken und Durchbrüche werden nur intern geprüft.

– Risiko: Kritische Schwachstellen werden zu spät oder gar nicht publik. - Asymmetrische Kryptobrüche

– Wenn ein Akteur Q‑Day zuerst erreicht, kann er still mitlesen, während alle anderen glauben, ihre Systeme seien sicher.

– Risiko: Langfristige, verdeckte Ausnutzung („Harvest Now, Decrypt Later“). - Abhängigkeit statt Resilienz

– Staaten, Firmen oder Individuen ohne eigenen Zugang müssen vertrauen – auch wenn Entscheidungen politisch motiviert sind.

– Risiko: Machtmonopole können Standards verzögern oder missbrauchen. - Langsamere PQC-Umstellung

– Kommerzielle Interessen oder Geheimhaltungsstrategien können den Rollout neuer Sicherheitsverfahren bremsen.

– Risiko: Verlängerte Verwundbarkeit. - Sicherheitsgewinn nur für wenige

– Eliten können ihre Systeme absichern, bevor sie die neuen Verfahren freigeben.

– Risiko: „Zwei-Klassen-Kryptografie“ – geschützt wird, wer im Club ist.

Kurz:

Ohne Commons bedeutet Sicherheit vor allem Sicherheit für die Mächtigen. Für alle anderen heißt es: Spätere Updates, weniger Einblick, mehr Abhängigkeit.

Willst du, dass ich daraus direkt eine Vergleichstabelle „Sicherheit MIT vs. OHNE Commons“ erstelle?

| Kriterium | Sicherheit MIT Commons | Sicherheit OHNE Commons |

|---|---|---|

| Transparenz | Offenlegung von Schnittstellen, Audits, Repro-Pipelines | Blackbox-Entwicklung, späte/keine Offenlegung |

| Fehlerfindung | Viele Augen, schnellere CVE-Meldungen | Wenige Prüfer, Latenz bei kritischen Luecken |

| PQC-Einführung | Default-Pflicht, schneller Rollout | Verzögert durch Geschäftsmodelle/Geheimhaltung |

| Kryptorisiko Q‑Day | Verteiltes Wissen, fruehe Gegenmassnahmen | Asymmetrischer Kryptobruch, stilles Mitlesen |

| Governance | Multi-Stakeholder, dokumentierte Entscheidungen | Oligopol/Geheimdienste setzen Prioritaeten |

| Vendor-Lock-in | Niedrig (offene APIs, Multi-Backend) | Hoch (proprietaere Stacks) |

| Resilienz | Keine Single Points of Failure | Abhaengigkeit von wenigen Gatekeepern |

| Dual-Use-Kontrolle | Oeffentliche Do/Don’t‑Policy, Veto-Boards | Intransparente Nutzung, kaum externe Checks |

| Wissenszugang | Offenes Curriculum, breite Qualifizierung | Exklusives Know-how, Talent-Sog zu wenigen |

| Incident-Response | Community-CERT, gemeinsame Patches | Isolierte Fixes, Patch-Gaps entlang der Lieferkette |

Kurzfazit

Mit Commons steigt Sicherheit durch Transparenz, Geschwindigkeit und verteilte Kontrolle. Ohne Commons steigt Sicherheit vor allem fuer wenige – waehrend Risiko und Abhaengigkeit fuer alle anderen wachsen.

(…)

(…)

Nächster Titel

(…)

(…)

(…)

Nächster Titel

(…)

(…)

(…)

Nächster Titel

(…)

(…)

(…)

Nächster Titel

(…)

(…)

(…)

(…)

Nächster Titel

(…)

(…)

Nächster Titel

(…)

(…)

(…)

Wie ich mit den Möglichkeiten von @openAI arbeite?

Links, Threads, zu verarbeitende Hinweise…

(…)

(…)

(…)

Offene Blogeinträge, welche zu diesem Thema passen…

(…)

(…)

(…)

Textsorte: (1) Traum, (2) Blitz, (3) Bekenntnis, (4) Memo, (5) Märchen, (6) Drama, (7) Tabu

Arbeitsform: Dokumentation, Listenbildung, Work in Progress

Anlass: (…)

TL;DR: (…)

Bildquelle: (…)

URL/Hashtag: (…)

Stefan M. Seydel, aka sms, aka sms2sms in «Zürcher Festspiel 1901″ (2019, Fotocredit: Charles Schnyder): Twitter, Wikipedia (Lemma), Youtube (aktuell), Soundcloud, Mastodon, Instagram (gesperrt), Snapchat, TikTok, Twitch, t.me/WikiDienstag (Nicht in Betrieb) | Exklusiv: speakerbooking.ch/sms2sms

About @sms2sms, aka Stefan M. Seydel/sms ;-)

Stefan M. Seydel, Jahrgang 1965, ist Unternehmer, Sozialarbeiter und Künstler. Er machte nach einer Berufslehre als Hochbauzeichner einen Bachelor in Soziale Arbeit in St. Gallen und einen Master in der gleichen Disziplin bei Silvia Staub-Bernasconi in Berlin. Seine überwiegend selbstständige Tätigkeit kreist um das Thema der Entwicklung und Realisierung von Pilot- und Impulsprojekten für renommierte Auftraggeberinnen.

Als Künstler hat er Ausstellungen und Performances auf internationaler Ebene präsentiert, darunter in der Royal Academy of Arts in London, dem Deutschen Historischen Museum in Berlin oder einer Einzelausstellung “Kunst Macht Probleme” in der Crypta Cabaret Voltaire, Birthplace of DADA in Zürich. Er wurde mit dem Migros Jubilée Award in der Kategorie Wissensvermittlung ausgezeichnet und hat diverse Ehrungen durch Webby Awards für seine Arbeit mit rocketboom.com erhalten.

Stefan war Jury-Mitglied des Next Idea Prix Ars Electronica 2010 und war drei Jahre Mitglied der Schulleitung des Gymnasiums Kloster Disentis. Sein Wissen und seine Erfahrung im Bereich der Information und Technologie haben ihm auch dabei geholfen, mit Statistik Stadt Zürich und Wikimedia Schweiz unter WikiDienstag.ch zusammenzuarbeiten.

Sein Engagement im Bereich der freiwilligen Arbeit führte ihn in das Präsidium Internationaler Bodensee Club (Leitung Fachgruppe Wissenschaft) oder für einige andere Jahre als Vice-Präsident des von Paul Watzlawick initiierten P.E.N.-Club Liechtenstein. Seydel hat unter ((( rebell.tv ))) zwei Bücher zusammen mit seiner Partnerin Tina Piazzi veröffentlicht, viele Kolumnen, Fachtexte und journalistische Texte publiziert.

Seine Arbeit auf Social Media nutzt er als Microblogging. In seinem Blog verarbeitet er seine Themen. Einige davon werden auf Anfragen zu lesbaren Texten vertieft, andere werden zu Vorträgen ausgebaut. Bei Carl Auer Verlag in Heidelberg, sammelt er “Elemente einer nächsten Kulturform”. Seine Entwicklungen im Kontext der sozialräumlichen Intervention (“Arbeit am Sozialen”) machen konkrete Vorschläge in Bezug auf die Beantwortung der Sozialen Frage.

Nach 12 Jahren Berlin und 6 Jahren Zürich zog er aber in seiner zweiten Lebenshälfte vom Bodensee der Rheinquelle entgegen nach Dissentis/Mustér und hat seine Reisetätigkeit fast ganz eingestellt. Dafür macht er umsomehr sogenannte Passadis und #Feedlogs (Orgiastik). Das sind Arbeitsmeetings an intentionalen Fragen in einem Lifestream. (so?) Text supported by #TaaS

Aus Band 2 von: Tina Piazzi & Stefan M. Seydel, Junius-Verlag Hamburg | pdf: Band 1, 2009 | Band 2, 2010

#dfdu = DIE FORM DER UNRUHE | blog: dissent.is | about: dissent.is/sms | dissent.is/muster

Indizis locals tras il canal WhatsApp.